Warum in Projekten heute auf Spark gesetzt wird– und wie sich Hadoop und Spark ergänzen

1. Einleitung: Von Big Data zu Big Insights

In den letzten Jahren haben Unternehmen erkannt, dass Daten nicht nur gesammelt, sondern auch sinnvoll verarbeitet werden müssen. Big Data, wie wir es im letzten Blog beschrieben haben, ist längst kein Schlagwort mehr, sondern Grundlage für strategische Entscheidungen, Innovationen und Wettbewerbsvorteile.

Doch mit der schieren Datenmenge wächst auch die Herausforderung: Wie lassen sich Terabytes oder Petabytes an Kundendaten, Transaktionslogs, IoT-Streams oder Social-Media-Beiträgen so effizient verarbeiten, dass daraus in Echtzeit Erkenntnisse entstehen?

Die Antwort liegt in Technologien, die speziell für die parallele, verteilte Datenverarbeitung entwickelt wurden. Lange Zeit galt Apache Hadoop mit seinem MapReduce-Ansatz als Synonym für Big-Data-Verarbeitung. Heute jedoch führt kaum ein Weg mehr an Apache Spark vorbei – einer Plattform, die viele der Limitierungen von Hadoop überwindet und den Weg in eine neue Ära ebnet.

2. Rückblick: Hadoop und MapReduce als Pioniere

Als Hadoop 2006 in den Fokus rückte, revolutionierte es die Art und Weise, wie Unternehmen mit großen Datenmengen umgehen konnten.

Herzstück war das MapReduce-Paradigma:

- Map: Daten werden in kleinere Teilaufgaben zerlegt und parallel auf vielen Knoten verarbeitet.

- Shuffle: Die Ergebnisse werden neu sortiert und verteilt.

- Reduce: Teilresultate werden zusammengeführt und verdichtet.

So konnten plötzlich riesige Datenmengen in einem verteilten Cluster verarbeitet werden – robust, fehlertolerant und relativ günstig mit Standardhardware.

Doch MapReduce hatte Schwächen:

- Verarbeitung erfolgte batch-basiert, also nicht in Echtzeit.

- Jeder Verarbeitungsschritt erforderte Speicherzugriffe auf Festplatten, was zu Verzögerungen führte.

- Für komplexe Workflows (z. B. iterative Algorithmen im Machine Learning) war MapReduce unflexibel und langsam.

Die Konsequenz: Hadoop wurde zum Grundstein für Big Data, war aber kein Allheilmittel.

3. Was ist Apache Spark?

Apache Spark wurde 2009 am AMPLab der University of California, Berkeley entwickelt, um genau diese Schwächen von Hadoop zu adressieren. Seit 2014 ist Spark ein offizielles Top-Level-Projekt der Apache Software Foundation – und hat sich rasant als Standardtechnologie etabliert.

Kurz gesagt:

Spark ist eine einheitliche In-Memory-Plattform für Big-Data-Analyse, Streaming, Machine Learning und Graphverarbeitung.

Die entscheidende Innovation: Spark verarbeitet Daten im Arbeitsspeicher (RAM) statt permanent auf die Festplatte zu schreiben. Dadurch werden Analysen nicht nur schneller, sondern auch flexibler.

Spark gilt heute als das „Schweizer Taschenmesser“ der Big-Data-Verarbeitung – eine Plattform, die verschiedene Anwendungsfälle unter einem Dach vereint.

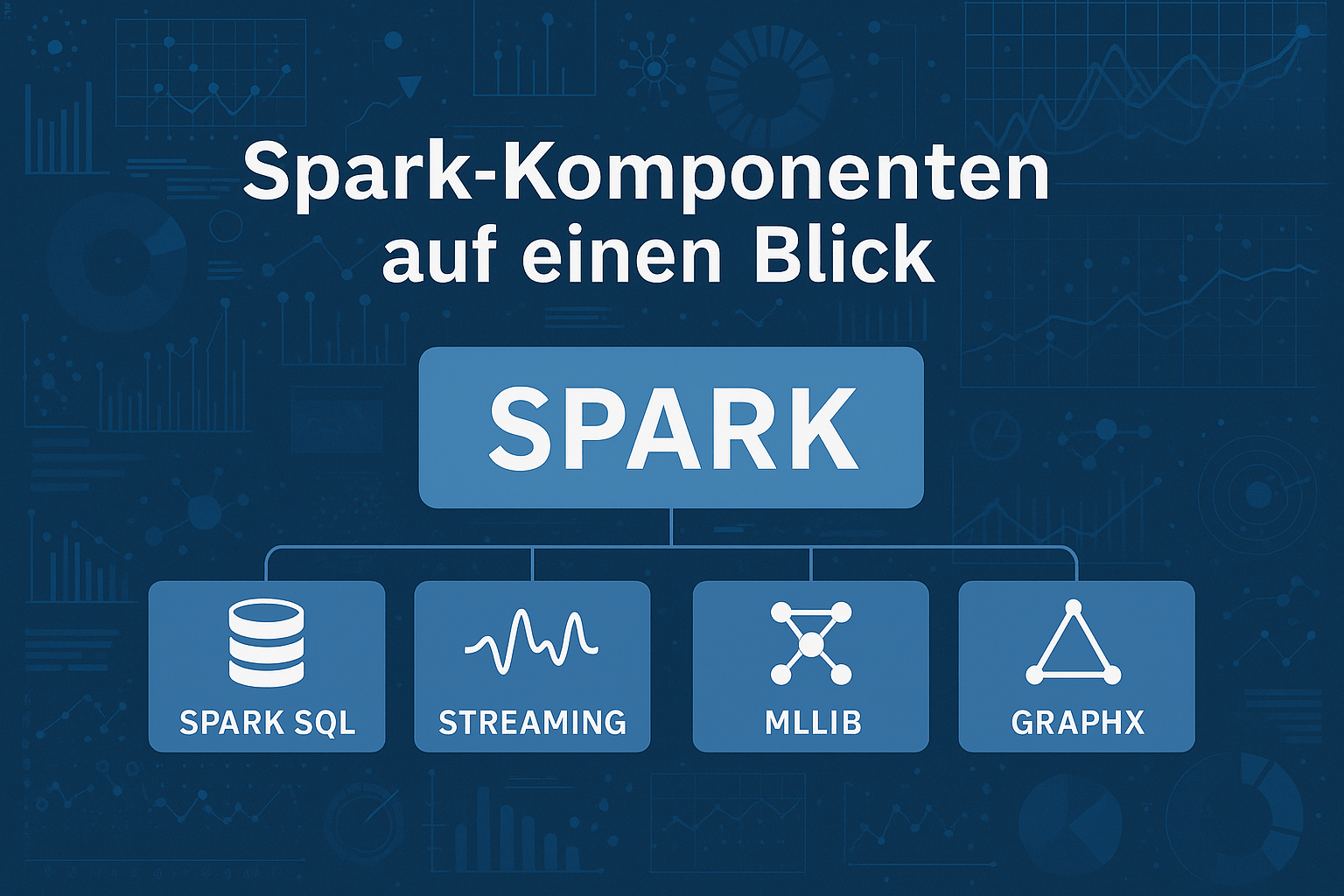

4. Komponenten von Apache Spark

Apache Spark ist modular aufgebaut und bietet mehrere Kernkomponenten, die zusammen eine umfassende Analyseplattform bilden:

- Spark Core: Herzstück für Speicherverwaltung, Task Scheduling und RDD-Verarbeitung (Resilient Distributed Datasets).

- Spark SQL: Erlaubt die Verarbeitung strukturierter Daten mit SQL-Syntax. Ideal für DataFrames und Integration mit Data Warehouses.

- Spark Streaming / Structured Streaming: Für Echtzeitverarbeitung von Datenströmen (z. B. IoT, Social Media, Sensoren).

- MLlib: Machine-Learning-Bibliothek mit Algorithmen für Klassifikation, Regression, Clustering und Recommender-Systeme.

- GraphX: Für Analyse und Visualisierung komplexer Netzwerke (z. B. soziale Netzwerke oder Supply Chains).

Damit vereint Spark Funktionen, die bei Hadoop oft erst durch zusätzliche Tools realisiert werden konnten.

5. Vorteile von Apache Spark

Warum entscheiden sich heute so viele Unternehmen für Spark?

- Geschwindigkeit: Bis zu 100-mal schneller als MapReduce durch In-Memory-Verarbeitung.

- Flexibilität: Unterstützung von SQL, Machine Learning, Streaming und Graphen in einer Plattform.

- Benutzerfreundlichkeit: APIs für Java, Scala, Python (PySpark) und R erleichtern die Arbeit für Entwickler und Data Scientists.

- Echtzeitfähigkeit: Anders als Hadoop ist Spark in der Lage, Datenströme nahezu in Echtzeit zu verarbeiten.

- Integration: Spark kann auf Hadoop HDFS laufen, in Cloud-Umgebungen (AWS, Azure, Databricks) integriert werden oder eigenständig arbeiten.

6. Anwendungsbereiche von Apache Spark

Spark kommt heute in zahlreichen Branchen zum Einsatz:

- Customer Analytics: Personalisierte Marketingkampagnen, Kunden-Segmentierung, Next-Best-Offer.

- Finanzwesen: Echtzeit-Scoring von Kreditanträgen oder Fraud Detection.

- Industrie/IoT: Predictive Maintenance durch Analyse von Maschinendaten.

- Logistik: Optimierung von Lieferketten durch Streaming-Analysen.

- Gesundheitswesen: Verarbeitung von Bilddaten und Genomsequenzen.

- Adressmanagement: Bereinigung und Standardisierung großer Kundendatenbestände, Reduktion von Dubletten sowie Anreicherung und Aggregation von Adress- und Kontaktdaten. Dadurch wird die Datenqualität nachhaltig verbessert und eine zuverlässige Basis für Analysen, Customer-Relationship-Management und Compliance geschaffen.

Besonders spannend: Durch MLlib können Machine-Learning-Modelle direkt auf Big Data angewandt werden – ohne dass Daten zwischen Systemen hin- und hergeschoben werden müssen.dt werden – ohne dass Daten zwischen Systemen hin- und hergeschoben werden müssen.

7. Apache Hadoop vs. Apache Spark – Gemeinsamkeiten und Unterschiede

Gemeinsamkeiten:

- Beide sind Open Source und für die verteilte Verarbeitung großer Datenmengen entwickelt.

- Beide Systeme sind fehlertolerant und können nach Ausfällen Daten rekonstruieren.

- Beide werden oft kombiniert genutzt: Spark auf HDFS als Speicherbasis.

Unterschiede:

| Kriterium | Hadoop (MapReduce) | Apache Spark |

|---|---|---|

| Architektur | Verarbeitung batch-basiert, Festplattenspeicher | In-Memory-Verarbeitung, Daten im RAM |

| Leistung | Langsamer, hohe Latenz | Bis zu 100x schneller, Echtzeit möglich |

| Kosten | Günstig (Festplattenbasiert, Standard-HW) | RAM-intensiv, daher teurer |

| Skalierbarkeit | Einfach durch Hinzufügen neuer Knoten | RAM-Skalierung erforderlich |

| Machine Learning | Keine nativen Funktionen, externe Tools nötig | Integrierte MLlib-Bibliothek |

| Sicherheit | Umfangreiche Security-Features | Grundlegende Sicherheit, abhängig von Umgebung |

8. Spark in der Cloud

Während Hadoop traditionell oft On-Premise betrieben wurde, ist Spark eng mit Cloud-Plattformen verknüpft.

- AWS: Spark auf EMR oder mit S3 als Speichersystem (https://aws.amazon.com/de/emr/features/spark/).

- Azure: Spark in Synapse oder Azure Databricks (https://learn.microsoft.com/de-de/azure/synapse-analytics/spark/apache-spark-overview).

- Databricks: Von den Spark-Erfindern gegründet, bietet eine komplett verwaltete Entwicklungs- und Analyseplattform (https://www.databricks.com/de).

Cloud-Umgebungen reduzieren den administrativen Aufwand erheblich: Cluster werden automatisch skaliert, Updates erfolgen zentral, und Nutzer können sich auf die Datenanalyse konzentrieren.

9. PySpark – Spark für Python-Nutzer

Viele Data Scientists arbeiten bevorzugt mit Python – und genau hier setzt PySpark an.

- PySpark bietet eine intuitive API, die sich an Pandas orientiert.

- Datenanalysen, ETL-Pipelines und Machine-Learning-Modelle können in Python entwickelt und auf Spark-Cluster skaliert ausgeführt werden.

- Einziger Nachteil: PySpark gilt als etwas langsamer als die nativen Scala/Java-APIs.

Trotzdem ist PySpark der Standard für Data-Science-Workflows mit Spark geworden.

10. Machine Learning mit Spark (MLlib)

MLlib macht Spark zu einer attraktiven Plattform für KI/ML-Anwendungen:

- Algorithmen für Klassifikation, Regression, Clustering und Recommendation.

- Unterstützung für Pipelines, die von Feature Engineering bis zum Modelltraining reichen.

- Integration mit Deep-Learning-Frameworks wie TensorFlow oder Keras.

Beispiel: Ein Retail-Unternehmen kann Spark nutzen, um Kaufhistorien von Millionen Kunden auszuwerten, Modelle für Produktempfehlungen zu trainieren und diese Empfehlungen in Echtzeit im Online-Shop auszuliefern.

11. Apache Spark und Datenqualität – ein Muss für den Erfolg

So mächtig Spark ist – ohne saubere Daten bleibt der Nutzen begrenzt.

Gerade bei Kunden- und Adressdaten gilt:

- Dubletten verfälschen Analysen.

- Fehlerhafte Adressen verursachen Kosten in Logistik und Marketing.

- Unvollständige Stammdaten führen zu falschen Vorhersagen.

Erst durch Data Governance und konsequentes Datenmanagement wird Spark zum Erfolgsfaktor – sonst bleibt es bei schönen Dashboards ohne verlässliche Aussagekraft.

12. Zusammenfassung und Ausblick

Apache Spark ist der logische nächste Schritt nach Hadoop MapReduce. Es kombiniert Geschwindigkeit, Flexibilität und Vielseitigkeit und wird zum Rückgrat moderner datengetriebener Unternehmen.

Doch: Spark ist kein Selbstläufer. Entscheidend sind weiterhin Datenqualität, Governance und ein klarer Businessfokus.

Während Hadoop den Weg für Big Data geebnet hat, ist Spark heute die Plattform, die Unternehmen wirklich in die Lage versetzt, aus Daten in Echtzeit Wert zu generieren – sei es durch präzisere Kundenansprache, bessere Prognosen oder neue Geschäftsmodelle.

Neugierig geworden?

Wenn Sie mehr über Big-Data-Technologien und den praktischen Einsatz von Spark erfahren möchten, sprechen Sie uns gerne an:

https://address-consulting.com/

Ein Kommentar zu “Von MapReduce zu Apache Spark – die Evolution der Big-Data-Technologien”